2月16日,OpenAI正式发布文生视频AI大模型Sora,并发布48个文生视频案例及技术报告。Sora能够根据自然语言的提示词生成最长60秒的连贯视频,并支持静态图生视频、视频扩展和缺失帧填充、多视频过渡连接等功能。从目前发布的视频样片看,Sora生成的视频画面细节和真实程度与实拍视频几乎无异。Sora作为OpenAI发布的首个文生视频模型,不仅能准确呈现细节,还能生成具有丰富情感的角色,对AIGC行业来说是一个重要的里程碑,也被认为是迈向通用人工智能(AGI)的重要里程碑。

我们认为文生视频大模型所需训练数据的参数规模、运算能力和存储要求会显著大于文本和图像,未来有望带动AI芯片、HBM等高性能存储、服务器、光模块等行业的需求持续高增长。接下来,华强电子产业研究所将持续关注AI产业链发展与机遇。

此文为系列专题之AI芯片篇。

01 AI芯片是算力基础设施中的核心硬件,是构筑高算力的基础

由于生成式人工智能(生成式AI)在全球各行各业的重要性日益提高,在全球企业纷纷布局AI技术的大趋势刺激下,市场对科技行业,尤其是对那些芯片公司抱有极高的期望值。毕竟所有AI技术背后都离不开算力支撑,而算力的背后则完全基于AI芯片这一最底层基础硬件。

从技术架构来看,AI芯片可分为GPU(图形处理器)、FPGA(现场可编程阵列)、ASIC(专用集成电路)和类脑芯片,同时CPU也可用于执行通用AI计算。其中,GPU是较为成熟的通用性人工智能芯片,FPGA和ASIC则是针对人工智能需求特征的半定制和全定制芯片,类脑芯片是一种模拟人脑神经元结构的芯片,类脑芯片的发展尚处于起步阶段。

目前大模型运算主要使用的AI芯片就是拥有超高算力、深度学习能力的GPU。GPU(Graphics Processing Unit)最初专用于图形处理制造,后逐渐应用于计算。其内部包含大量的运算单元核心,尽管单个核心缓存较小,逻辑功能简单,仅能执行有限类型的逻辑运算操作,但其多核心架构天然适合执行复杂的数学和几何计算,且科学计算领域通用性较高,相比CPU,综合性能更好。

现阶段,全球GPU市场基本被NVIDIA、Intel和AMD三家垄断。Intel凭借其集成显卡在桌面端的优势占据最大的市场份额。在独立显卡领域,NVIDIA与AMD双雄垄断市场,NVIDIA市占率在80%以上。在数据中心赛道,Trendforce数据显示,2023年的AI芯片市场中NVIDIA出货量约占60-70%,几家互联网巨头的自研ASIC芯片约占20%。如果仅看数据中心GPU产品,则NVIDIA A100、H100 等产品在模型训练等方面几乎没有可替代的对手。

02 AI芯片市场规模有望向千亿美元跃升

高性能计算芯片的需求有望从百亿美元级向千亿美元级跃升。根据市场研究机构Gartner预测,2024年AI芯片市场规模将较上一年增长25.6%,达671亿美元,预计到2027年,AI芯片市场规模预计将是2023年规模的两倍以上,达到1194亿美元。

但是NVIDIA最强大竞争对手——AMD对于未来AI芯片市场的预期更加乐观。在“Advancing AI”发布会上,NVIDIA最强力竞争对手AMD将截至2027年的全球AI芯片市场规模预期,从此前预期的1500亿美元猛然上修至4000亿美元,而2023年AI市场规模预期仅仅为300亿美元左右,NVIDIA 2022年数据中心业务产品营收也仅为150亿美元。AI芯片市场指数级增长的市场空间必将引起各大企业更多的行动。

03 全球科技巨头加大AI芯片投入,加快产品升级,布局生态建设

目前在AI芯片领域,NVIDIA可谓“一家独大”,市占率接近90%。但全球大模型领域的竞争依然白热化。大模型竞赛带来上游算力需求提升,科技巨头纷纷加大芯片投入,以缓解大模型所需AI芯片短缺情况。OpenAI首席执行官Sam Altman制定了雄心勃勃的AI芯片计划,目标筹集5-7万亿美元,改造全球半导体产业,推动通用人工智能发展。软银孙正义也计划筹措1000亿美元成立一家AI芯片企业。同时为应对潜在的威胁,NVIDIA也建立一个新的业务部门,专注于为其他公司设计定制芯片,包括先进的AI处理器。

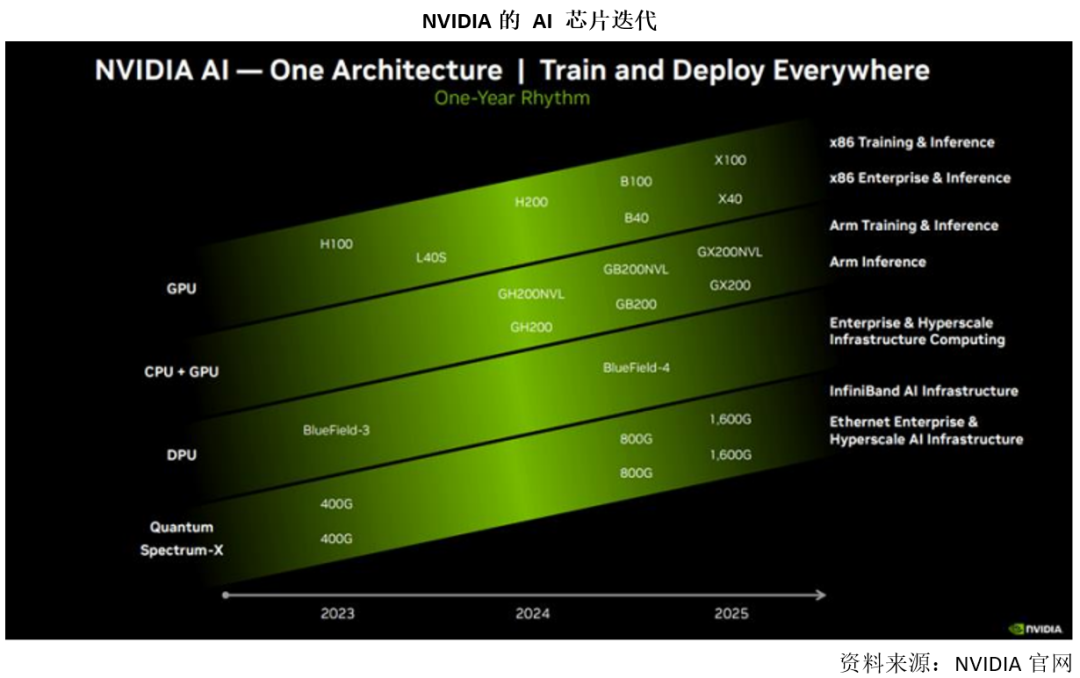

• NVIDIA产品升级节奏提速

作为AI芯片的先发者,NVIDIA享受了生成式AI崛起过程中算力行业的高速成长。NVIDIA数据中心AI芯片主要收入来自产品A100(2020年推出),H100(2022年推出),以及既可用于推理也可用于训练的L40S。预计后续推出新产品:公司已经于2023年11月份推出H100的HBM3E升级版本H200(2023年),预计2024年Q2交付。NVIDIA预估2024年、2025年将分别推出B100、X100,B100或将于2024年二季度推出。可见NVIDIA正把产品周期加快到每年一次,预估升级节奏的提速将持续推动产品单价值量增长,也有助于拉开和对手差距。此外,NVIDIA也发布了Grace CPU超级芯片和集成Grace CPU、H100 GPU的GH200超级芯片两款产品,第一代GH200(HBM3版本)于23Q3发售、第二代GH200(HBM3E版本)预计在24Q2发售,来应对AMD MI300(也是CPU+GPU)竞争。

• AMD追赶硬件,并积极构筑生态

AMD为仅次于NVIDIA的高性能GPU厂商。AMD凭借MI300芯片的出色表现,在AI芯片领域已取得一席之地。MI300系列GPU在性能上表现出色,已可胜任AI大模型的推理和训练任务,AMD已规划后续多代GPU产品,将持续迭代。AMD认为,MI300X内存是NVIDIA H100产品的2.4倍,内存带宽是H100的1.6倍,进一步提升了性能。MI300X新款芯片较NVIDIA的H100性能最多可以提升60%。当前Microsoft、Meta、甲骨文和其他云提供商宣布部署MI300X;Dell Technologies、HPE、联想、Supermicro等宣布推出全新AMD Instinct MI300企业级和HPC平台。

对标NVIDIA CUDA开发生态,AMD致力于打造ROCm6开发生态,有望为开发者提供NVIDIA CUDA 生态之外的新选项。AMD正加速构建自主开发生态并更新迭代ROCm。2023年12月AMD推出新版本ROCm 6.0。秉持先兼容CUDA再寻求培养自主开发生态的策略,未来AMD有望在日渐增长的开发者群体的帮助下实现生态的完善和成熟。

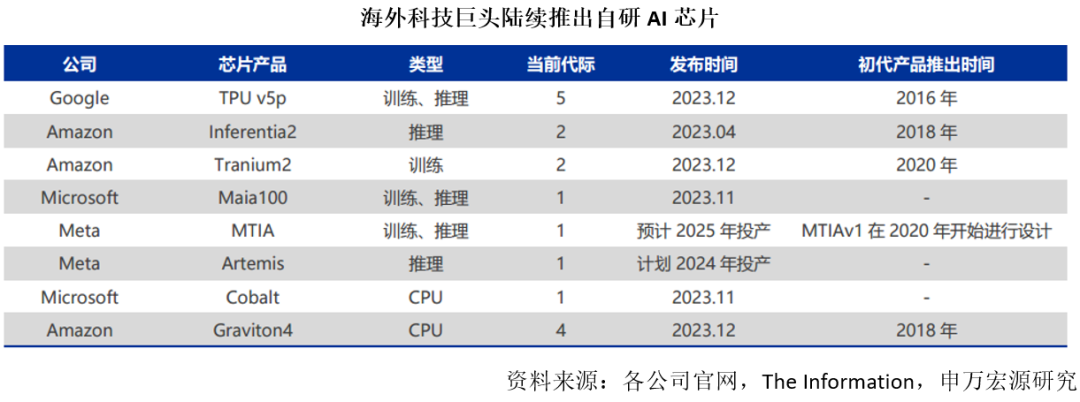

• 云厂商+Meta自研芯片使用比例提升

科技巨头一方面采购NVIDIA芯片,如Meta公布2024年将采购35万颗H100、微软也宣布2024年将大量购置B100;另一方面均布局自研AI芯片。除谷歌、亚马逊已拥有相对成熟的AI芯片外,微软和Meta的自研AI芯片都将于2024年投产,将成为GPU的重要补充。

对云厂商而言,更低的价格下自研AI芯片可大幅降低自有AI业务的算力成本,并可根据自有大模型的特点对AI芯片进行针对性设计,进一步实现优化成本。对于非云厂的AI企业而言,未来潜在的AI应用及大模型优胜企业将主动对算力成本进行优化,或有望选择性价比更高的AI芯片。价格更低的自研芯片使用比例有望增加。

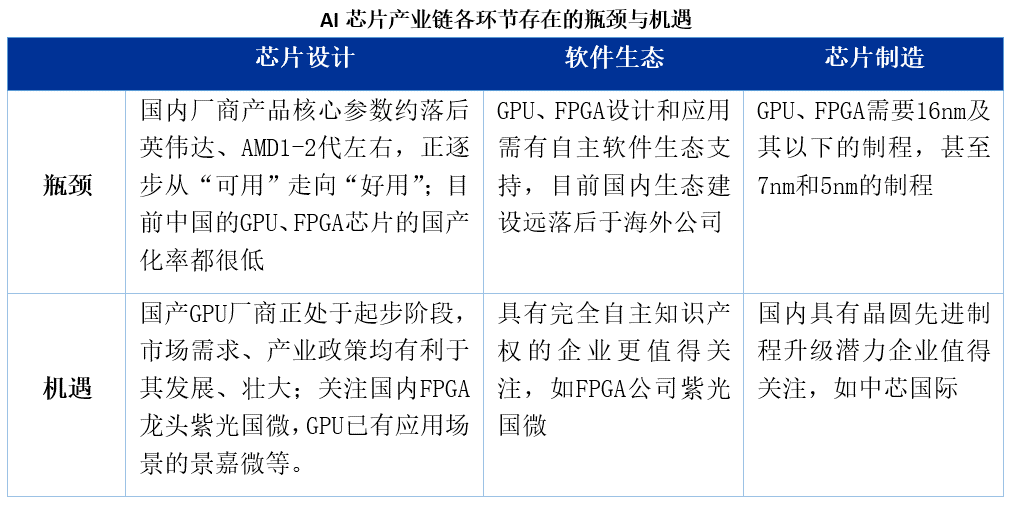

04 国内AI芯片产业链尚存瓶颈

近年来,国内GPU厂商开始迅速崛起,GPU产品也逐步上市。大多数国内GPU企业已发布1-3款相关产品,且大部分核心团队具有英伟达、AMD工作经历。目前,国内GPU厂商的产品核心参数约落后英伟达、AMD 1-2代左右,正逐步从“可用”走向“好用”。但也要看到,国内企业的GPU产品距离国际厂商还有一定的距离。

05 受生成式AI火热发展的市场驱动,AI芯片巨头已收割一波红利

ARM最新财季收入再创新高,业绩大超预期。ARM公司2024财年第三财季(公历年份2023年7-9月)总营收8.24亿美元,达历史新高,同比增长14%;调整后运营利润3.38亿美元,同比增长17%。ARM预计第四财季营收为8.5亿至9.0亿美元,四季度及2024全年营收指引中值分别上调1亿美元、1.6亿美元,预计汽车和AI等市场将在第四财季表现强劲。ARM公司业绩提升一方面来自手机架构正从旗下v8架构向可赋能AI能力的v9架构迭代升级,另一方面则是在云服务器和汽车类业务市场正拓展份额。

NVIDIA 2024财年以来表现抢眼。截至2024Q3财季(结束于2023年10月),NVIDIA季度收入约180亿美金,同比增长206%。其中,数据中心业务占比80%,游戏业务占比16%,专业可视化占比2%,自动驾驶业务占比1%。2024Q3财季,得益于AI算力需求强劲,NVIDIA数据中心业务同比增长279%,单业务收入亦创新高。NVIDIA 2024Q4财季的财报将于近期公布,值得期待。

全球越来越多科技公司参与布局AI技术的热潮,或将推动一场长达十年的AI繁荣发展时代。根据彭博行业研究分析师发布的一份最新报告,预计到2032年,包括训练人工智能系统所需AI芯片,以及AI软硬件等应用端在内的生成式AI市场总营收规模将从2022年的400亿美元增长到1.3万亿美元,这一市场可谓10年间有望翻32倍,以高达42%的复合速度高速增长。

以上部分观点引自华强电子产业研究所《AI芯片行业发展与机遇研究报告》一文。

华强电子产业研究所致力于打造开放合作平台,与企业/协会/园区等建立产业智库合作伙伴关系,提供行业咨询和报告交流。

合作请联系:

联系我们